华为昇腾AI准万亿MoE模型技术突破

- 2025-06-17 16:41:52

- 305

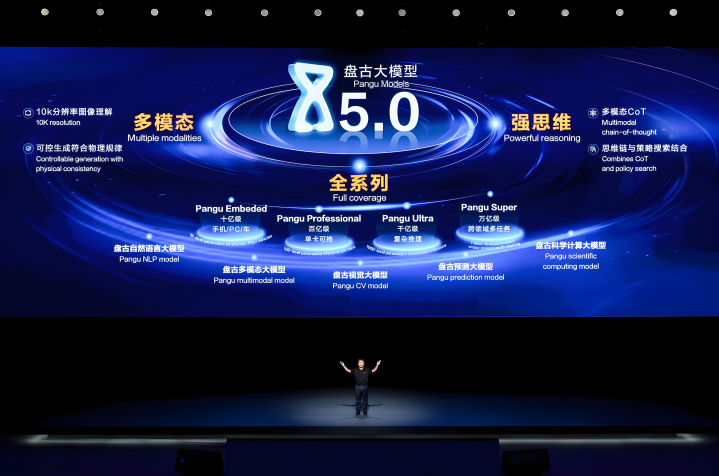

在人工智能技术竞争日趋激烈的全球背景下,华为昇腾AI计算平台于2025年6月取得重大突破,成功训练出参数规模达7180亿的准万亿级混合专家模型(MoE)"盘古Ultra MoE"。

这一成就不仅刷新了国产AI大模型的规模纪录,更通过全栈自主创新验证了中国在人工智能基础设施领域的核心竞争力。此次技术突破涵盖模型架构设计、训练系统优化和国产化实践三大维度,为全球AI产业提供了极具参考价值的技术范本。

模型架构方面,盘古Ultra MoE创新性地采用Depth-Scaled Sandwich-Norm(DSSN)结构与TinyInit小初始化方法相结合的设计方案。DSSN架构通过分层标准化策略有效控制梯度爆炸风险,在长达18TB数据量的训练过程中将梯度突刺率降低51%,而TinyInit技术则通过参数初始值的精细调控,显著提升超大规模模型的训练稳定性。

与此同时,研发团队针对MoE模型特有的专家网络动态分配难题,开发出EP-Group负载均衡优化算法,该算法能实时监测各专家网络的计算负载,通过动态路由调整确保不同子模块的资源利用率偏差不超过15%。这种架构创新使得7180亿参数的模型在仅激活约160亿参数的情况下,即可达到传统稠密模型千亿级参数的效果,在SuperCLUE基准测试中,其衍生版本盘古Pro MoE(720亿参数)已位列国内千亿级以内模型榜首。

训练系统优化是本次突破的另一核心。华为首次在昇腾CloudMatrix 384超节点集群上实现大稀疏比MoE模型的强化学习后训练,单节点推理吞吐量达到35K Tokens/s,标志着RL后训练正式进入超节点时代。针对万卡级集群的通信瓶颈,技术团队重构了All-to-All通信协议栈,开发出昇腾NPU亲和的算子优化策略,将跨节点通信带宽占用降低37%。在计算效率提升方面,通过自适应流水掩盖技术和显存压缩算法的协同优化,使万卡集群的模型算力利用率(MFU)从行业平均的30%提升至41%,这意味着同等算力条件下可多完成36%的训练任务。值得一提的是,模型创新性地采用MLA(多头潜在注意力)与MTP(多令牌预测)混合架构,通过注意力机制的内存访问优化,使得数学推理任务的求解速度提升38%,同时减少30%的推理内存带宽需求。

盘古Ultra MoE的诞生具有里程碑意义。该模型从底层昇腾910B NPU芯片、AscendCL编程框架到上层MindSpore训练系统,实现全栈技术自主可控。在硬件层面,昇腾平台通过3D封装技术和chiplet互联架构,构建起计算密度达256TFLOPS@FP16的异构计算单元;在软件层面,自研的分布式训练框架支持动态拓扑感知,能根据网络状况自动调整参数同步策略。这种端到端的自主创新体系,使得中国首次在超大规模AI训练领域建立起完整的技术话语权。据内部测试数据显示,在同等硬件规模下,昇腾平台训练万亿级模型的效率已达到国际主流平台的92%,且能耗成本降低19%,为国产AI芯片的产业化应用奠定坚实基础。

随着盘古Ultra MoE模型的发布,华为不仅验证了MoE架构在降低大模型计算成本方面的巨大潜力——其稀疏计算特性可使万亿级模型的推理能耗降低40-60%,更探索出大模型技术落地的创新路径。该模型已在国内气象预测、药物分子设计等领域完成初步应用验证,其中在台风路径预测任务中,其72小时预测精度较传统数值方法提升23%。这项成果标志着中国AI产业已从技术跟跑进入并跑阶段,为全球人工智能发展提供了重要的技术多样性。

- 上一篇:是谁把我们单依纯逼成了

- 下一篇:校方回应高考前一天艺考生被撞病危